Сучасний світ стрімко змінюється під впливом новітніх технологій, серед яких дедалі більшого поширення набуває діпфейк. Це поняття охоплює синтетичні медіа, включаючи зображення, відео та аудіо, створені за допомогою штучного інтелекту (ШІ), які зображують події або об’єкти, що не існують у реальності. Незважаючи на свої переваги, ця технологія викликає серйозні етичні та соціальні питання.

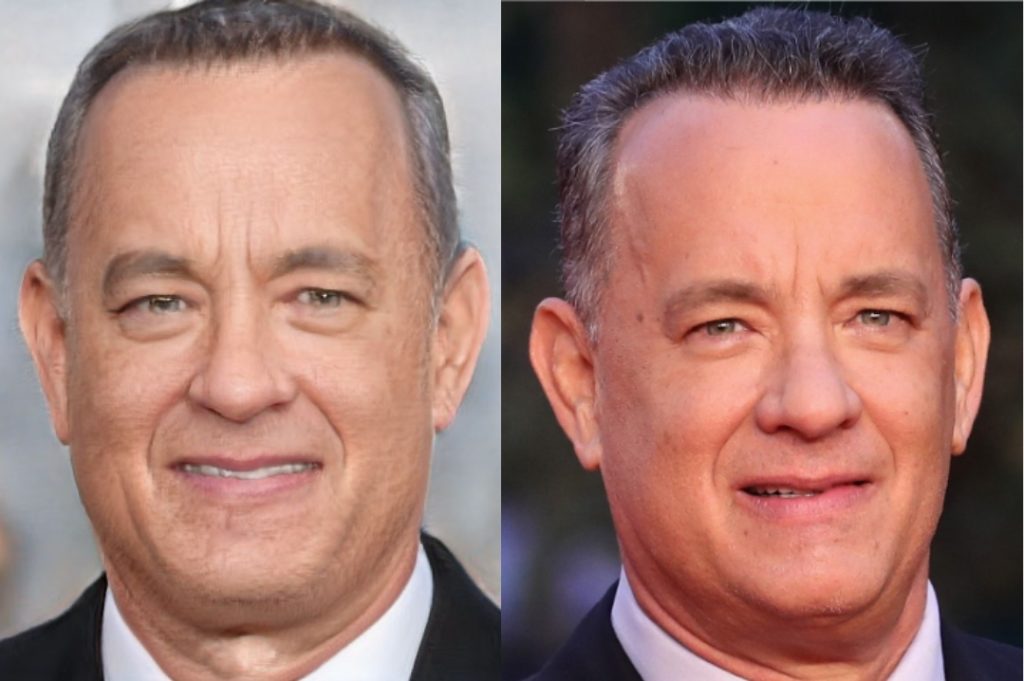

Сам термін «deepfake» поєднує в собі два слова: «deep», що походить від глибокого навчання — підвиду машинного навчання, і «fake», що підкреслює несправжність створеного контенту. Вперше його почали використовувати у 2017 році, коли на платформі Reddit з’явився субреддит, присвячений відео з заміною облич, що швидко привернули увагу користувачів.

Сфера використання діпфейків значно розширилася з часом. Окрім відомих випадків, коли технологія використовувалася для створення фальшивих відео за участі знаменитостей, з’явилися приклади, які стали вірусними. Наприклад, зображення Папи Франциска в пуховій куртці або відео колишнього президента США Дональда Трампа у конфлікті з поліцією. Ці події ніколи не відбувалися в реальному житті, але завдяки діпфейку вони виглядали напрочуд реалістично.

Процес створення діпфейків базується на використанні двох алгоритмів ШІ. Перший з них створює синтетичний контент, максимально схожий на оригінал, тоді як другий перевіряє, наскільки вірогідним є створений образ, і повідомляє про можливі недоліки. Завдяки постійній взаємодії цих алгоритмів створюються дедалі досконаліші підробки, які складно відрізнити від реальності.

Звукові діпфейки створюються шляхом навчання моделі ШІ на основі реальних аудіозаписів конкретної людини, що дозволяє точно відтворювати її голос у нових контекстах. Це відкриває можливості для використання технології у розважальних та освітніх цілях, але також створює ризики поширення дезінформації.

Ця технологія найчастіше асоціюється з негативними проявами, такими як створення фальшивих новин або використання для залякування та переслідування. Це явище вказує на серйозну загрозу для суспільства, особливо коли такі підробки стають інструментом політичної маніпуляції. Водночас це може мати і позитивне застосування. Так, наприклад, у кампанії проти малярії, відомий футболіст Девід Бекхем «заговорив» дев’ятьма різними мовами завдяки технології синтетичного відео. Також у музеї Сальвадора Далі у Флориді використали діпфейк для створення виставки, де великий художник ніби сам розповідає про своє життя.

Технологія має потенціал для використання в освіті та медицині. Наприклад, в освітньому процесі можна створювати інтерактивні уроки, відтворюючи історичні промови або інші важливі події. У медицині діпфейки можуть допомогти в діагностиці, наприклад, шляхом створення штучних зображень рідкісних захворювань для навчання алгоритмів ШІ. Це може значно покращити точність діагностичних процедур і допомогти уникнути проблем із конфіденційністю пацієнтів. Важливо усвідомлювати як її потенціал, так і ризики, що супроводжують цей стрімкий розвиток, щоб використовувати її на благо людства.